La Inteligencia Artificial (IA) es un campo de la informática que evoluciona rápidamente y tiene como objetivo crear máquinas inteligentes que puedan realizar tareas que típicamente requieren inteligencia humana, como la percepción visual, el reconocimiento de voz, la toma de decisiones y la traducción de lenguaje. En este artículo, proporcionaremos una breve descripción de la IA y su historia, cubriendo conceptos clave y terminología, como el aprendizaje automático, las redes neuronales y el aprendizaje profundo.

El objetivo de este articúlo es proporcionar una visión general completa del estado actual de la inteligencia artificial, incluyendo su historia, evolución y potencial futuro. Cubrirá una variedad de temas relacionados con la IA, incluyendo el aprendizaje automático, el procesamiento del lenguaje natural, la visión por computadora, la robótica y más.

¿Qué es la Inteligencia Artificial?

La Inteligencia Artificial es la capacidad de una máquina o programa informático para pensar y aprender como un ser humano. Es la simulación de procesos de inteligencia humana por máquinas, especialmente sistemas informáticos. Los algoritmos de IA están diseñados para hacer predicciones o decisiones mediante el procesamiento de grandes cantidades de datos e identificar patrones que los humanos pueden no ser capaces de detectar.

Historia y Evolución de la IA

La IA tiene una larga y fascinante historia que se remonta a la década de 1950. Con el tiempo, la IA ha evolucionado desde sistemas simples basados en reglas hasta sistemas más complejos que pueden aprender y tomar decisiones por sí solos. Hoy en día, la IA se utiliza en una amplia gama de aplicaciones, desde autos autónomos hasta asistentes virtuales.

- 1950: Alan Turing publica un documento sobre “Máquinas de Cómputo e Inteligencia”, proponiendo una prueba para determinar si una máquina puede exhibir un comportamiento inteligente equivalente o indistinguible del de un humano.

- 1956: John McCarthy, Marvin Minsky, Nathaniel Rochester y Claude Shannon organizan la Conferencia de Dartmouth, considerada el nacimiento de la IA como campo de estudio.

- 1957: John McCarthy inventa el lenguaje de programación Lisp, que se convierte en uno de los lenguajes de programación más utilizados en IA.

- 1958: Frank Rosenblatt inventa el perceptrón, un tipo de red neuronal artificial que puede aprender a reconocer patrones.

- 1961: James Slagle desarrolla SAINT (Symbolic Automatic INTegrator), un programa que podía resolver problemas de cálculo.

- 1963: Edward Feigenbaum y Julian Feldman desarrollan DENDRAL, el primer sistema experto, que podía identificar moléculas orgánicas desconocidas basándose en datos de espectrometría de masas.

- 1965: Joseph Weizenbaum desarrolla ELIZA, un programa de procesamiento de lenguaje natural que podía simular la conversación y la terapia humana.

- 1966: El primer robot, llamado Shakey, es desarrollado por el Instituto de Investigación de Stanford. Podía moverse por su entorno y realizar tareas simples.

- 1969: Marvin Minsky y Seymour Papert publican “Perceptrons”, un libro que critica las limitaciones de los perceptrones y retrasa la investigación en redes neuronales durante varios años.

- 1971: Terry Winograd desarrolla SHRDLU, un programa de procesamiento de lenguaje natural que podía entender y responder a comandos en un mundo de bloques simulado.

- 1974: Edward Feigenbaum y Edward Shortliffe desarrollan MYCIN, un sistema experto que podía diagnosticar infecciones bacterianas y recomendar tratamientos.

- 1979: Se celebra la primera conferencia de aprendizaje automático en Nashville, Tennessee, marcando el comienzo de un renovado interés en las redes neuronales y otras técnicas de aprendizaje automático.

- 1981: Comienza el primer invierno de la IA, un período de reducción de fondos e interés en la investigación de IA debido a expectativas altas y resultados decepcionantes.

- 1985: Los sistemas expertos se convierten en una aplicación popular de la IA, con empresas utilizándolos para tareas como la evaluación crediticia, el diagnóstico médico y la exploración de petróleo.

- 1986: Geoffrey Hinton, David Rumelhart y Ronald Williams desarrollan la retropropagación, un algoritmo para entrenar redes neuronales que ayuda a revitalizar el campo de las redes neuronales.

- 1990: Comienza el segundo invierno de la IA, causado por promesas exageradas y resultados insuficientes en los sistemas expertos y otras aplicaciones de IA.

- 1993: Rodney Brooks desarrolla la arquitectura de subsumación, una alternativa a la programación de IA tradicional que enfatiza la robótica basada en comportamiento y el control reactivo.

- 1997: Deep Blue de IBM derrota al campeón mundial de ajedrez Garry Kasparov en una partida de seis juegos, marcando un logro significativo en la IA y el aprendizaje automático.

- 2002: Cynthia Breazeal desarrolla Kismet, un robot que puede reconocer y responder a las emociones humanas.

- 2006: Geoffrey Hinton, Yann LeCun y Yoshua Bengio desarrollan el aprendizaje profundo, una técnica para entrenar redes neuronales con muchas capas que ayuda a revolucionar el reconocimiento de imágenes y voz.

- 2011: Watson de IBM derrota a campeones humanos en el programa de juegos Jeopardy!, demostrando la capacidad de la IA para entender y procesar el lenguaje natural.

- 2012: DeepMind de Google desarrolla una red neuronal que puede reconocer imágenes y clasificarlas en categorías con una precisión sin precedentes.

- 2015: AlphaGo de Google derrota al campeón mundial Lee Sedol en el juego de Go, un juego mucho más complejo que el ajedrez, demostrando el poder del aprendizaje profundo y el aprendizaje por refuerzo.

- 2018: OpenAI presenta GPT-2 (Generative Pre-trained Transformer 2), un modelo de lenguaje a gran escala que puede generar texto similar al humano. Inicialmente se mantiene en privado debido a preocupaciones sobre su posible mal uso, pero luego se lanza con algunas restricciones.

- 2019: Google lanza BERT (Bidirectional Encoder Representations from Transformers), un modelo de lenguaje que puede entender mejor el contexto de las palabras en una oración. Esto lleva a mejoras significativas en tareas de procesamiento del lenguaje natural como la respuesta a preguntas y el análisis de sentimientos.

- 2020: La pandemia de COVID-19 acelera el desarrollo y la adopción de la IA en la atención médica, con aplicaciones como el diagnóstico, el descubrimiento de medicamentos y el seguimiento de la propagación del virus.

- 2020: OpenAI lanza GPT-3, un modelo de lenguaje con 175 mil millones de parámetros, lo que lo convierte en uno de los modelos de IA más grandes y poderosos hasta la fecha. Genera texto que es casi indistinguible de la escritura humana y tiene muchas aplicaciones potenciales en campos como el procesamiento del lenguaje natural y la escritura creativa.

- 2021: AlphaFold 2 de DeepMind resuelve el problema del plegamiento de proteínas, un desafío de décadas en biología y bioquímica. Este avance tiene el potencial de revolucionar el descubrimiento de fármacos y otras áreas de investigación biomédica.

- 2021: Microsoft lanza un competidor de GPT-3, un modelo de lenguaje llamado Turing NLG, que es capaz de generar texto en respuesta a consultas de lenguaje natural con mayor eficiencia y precisión que los modelos anteriores.

- 2021: Se lanza GPT-3 (Generative Pre-trained Transformer 3) de OpenAI, que es el modelo de lenguaje más grande y poderoso hasta la fecha con 175 mil millones de parámetros.

- 2022: El uso de la IA en la atención médica continúa creciendo, con una mayor adopción de diagnósticos médicos, descubrimiento de medicamentos y planificación de tratamientos personalizados impulsados por la IA.

- 2022: Los chatbots y asistentes virtuales impulsados por la IA continúan mejorando, volviéndose más similares a los humanos en sus interacciones y expandiéndose a nuevas áreas como el asesoramiento en salud mental y financiero.

- 2022: Las consideraciones éticas en la IA se vuelven más prominentes, lo que lleva a una mayor regulación y supervisión de los sistemas de IA para garantizar la transparencia y la responsabilidad.

- 2023 y más allá: El uso de la IA en robótica y sistemas autónomos continúa avanzando, con drones y robots impulsados por la IA que se vuelven más comunes en industrias como la manufactura, el transporte y la agricultura.

- 2023 y más allá: Los sistemas de realidad virtual y aumentada impulsados por la IA se vuelven más inmersivos e interactivos, transformando industrias como los videojuegos, la educación y el comercio minorista.

- 2023 y más allá: Los avances en la computación cuántica y la IA llevan a avances en la resolución de problemas complejos, como el modelado del clima y el diseño de fármacos.

- 2023 y más allá: Las implicaciones éticas y sociales de la IA continúan siendo una preocupación importante, lo que lleva a un aumento de las llamadas a estándares y regulaciones globales para garantizar el desarrollo y uso responsable de la IA.

Conforme la IA continúa evolucionando y madurando, es probable que tenga un impacto cada vez más profundo en muchos aspectos de nuestras vidas, desde la atención médica y la educación hasta los negocios y el entretenimiento. Sin embargo, también plantea importantes preguntas éticas y sociales que deben ser cuidadosamente consideradas y abordadas. A medida que avanzamos hacia el futuro, es crucial que enfoquemos el desarrollo e implementación de la IA de manera reflexiva y responsable.

Glosario de Inteligencia Artificial

La inteligencia artificial (IA) es un campo de la informática que se ocupa de crear sistemas y programas capaces de realizar tareas que normalmente requieren inteligencia humana, como el reconocimiento de imágenes, el procesamiento del lenguaje natural, el aprendizaje automático o la toma de decisiones. En este glosario se presentan algunos de los conceptos y términos más importantes relacionados con la IA, así como sus definiciones y ejemplos de aplicación.

Aprendizaje Automático – Machine Learning

El aprendizaje automático es un subcampo de la IA que permite a las máquinas aprender a partir de datos sin ser programadas explícitamente. Los algoritmos de aprendizaje automático se pueden utilizar para hacer predicciones o decisiones basadas en datos y se utilizan en aplicaciones como el reconocimiento de imágenes y el procesamiento del lenguaje natural.

El aprendizaje automático es un subcampo de la inteligencia artificial que se enfoca en desarrollar algoritmos y modelos estadísticos que permiten a las computadoras aprender de los datos. Involucra el uso de técnicas matemáticas y estadísticas para permitir que las máquinas identifiquen patrones en los datos y hagan predicciones o decisiones basadas en esa información. En esta guía, profundizaremos en el concepto de aprendizaje automático, cubriendo temas y aplicaciones clave.

Conceptos clave:

- Aprendizaje supervisado: Un tipo de aprendizaje automático donde el algoritmo se entrena en un conjunto de datos etiquetados, lo que significa que se asigna una etiqueta u resultado a cada punto de datos. El algoritmo aprende a identificar patrones en los datos que están asociados con las etiquetas, y luego utiliza este conocimiento para predecir la etiqueta para nuevos datos no vistos.

- Aprendizaje no supervisado: Un tipo de aprendizaje automático donde el algoritmo se entrena en un conjunto de datos no etiquetados, lo que significa que no hay etiquetas o resultados preasignados. En su lugar, el algoritmo intenta identificar patrones en los datos basados en similitudes o diferencias entre los puntos de datos.

- Aprendizaje por refuerzo: Un tipo de aprendizaje automático donde el algoritmo aprende interactuando con un entorno y recibiendo retroalimentación en forma de recompensas o castigos. El algoritmo aprende a tomar acciones que maximizan las recompensas que recibe y, con el tiempo, se vuelve mejor para lograr sus objetivos.

- Redes neuronales: Un tipo de modelo de aprendizaje automático inspirado en la estructura del cerebro humano. Las redes neuronales consisten en nodos interconectados que procesan información y toman decisiones basadas en esa información.

- Aprendizaje profundo: Un tipo de aprendizaje automático que utiliza redes neuronales con múltiples capas para aprender patrones complejos en los datos. El aprendizaje profundo se utiliza a menudo para tareas como reconocimiento de imágenes, procesamiento del lenguaje natural y reconocimiento de voz.

- Regresión: Un tipo de algoritmo de aprendizaje automático utilizado para predecir valores continuos, como precios de acciones o precios de viviendas.

- Clasificación: Un tipo de algoritmo de aprendizaje automático utilizado para predecir resultados categóricos, como si un cliente comprará un producto o no.

- Agrupamiento: Un tipo de algoritmo de aprendizaje no supervisado utilizado para agrupar puntos de datos similares juntos.

- Reducción de dimensionalidad: Una técnica utilizada para reducir el número de características o variables en un conjunto de datos, lo que facilita su análisis y visualización.

- Extracción de características: Una técnica utilizada para identificar características o variables importantes en un conjunto de datos, que luego se pueden utilizar para construir modelos de aprendizaje automático.

- Sobreajuste: Un problema común en el aprendizaje automático donde el algoritmo aprende a ajustarse demasiado a los datos de entrenamiento, lo que resulta en un rendimiento deficiente en nuevos datos no vistos.

- Subajuste: Un problema común en el aprendizaje automático donde el algoritmo es demasiado simple para capturar los patrones subyacentes en los datos, lo que resulta en un rendimiento deficiente tanto en los datos de entrenamiento como en los de prueba.

- Validación cruzada: Una técnica utilizada para evaluar el rendimiento de los modelos de aprendizaje automático dividiendo los datos en conjuntos de entrenamiento y prueba, y luego entrenando y probando repetidamente el modelo en diferentes subconjuntos de los datos.

- Equilibrio sesgo-varianza: Un concepto fundamental en el aprendizaje automático que implica equilibrar el intercambio entre la complejidad del modelo (varianza) y su capacidad para generalizar a nuevos datos (sesgo).

- Métodos de conjunto: Una técnica utilizada para combinar múltiples modelos de aprendizaje automático para mejorar el rendimiento.

- Árboles de decisión: Un tipo de modelo de aprendizaje automático que utiliza una estructura similar a un árbol para tomar decisiones basadas en características de los datos.

- Bosques aleatorios: Un método de conjunto que utiliza múltiples árboles de decisión para mejorar el rendimiento y reducir el sobreajuste.

- Reforzamiento de gradiente: Un método de conjunto que utiliza múltiples modelos débiles para crear un modelo fuerte.

- Máquinas de vectores de soporte (SVM): Un tipo de modelo de aprendizaje automático utilizado para tareas de clasificación y regresión que implica encontrar un hiperplano que separe los datos en diferentes clases.

Procesamiento del Lenguaje Natural

El procesamiento del lenguaje natural (PLN) es un subcampo de la IA que se centra en la interacción entre las computadoras y los humanos utilizando el lenguaje natural. Los algoritmos de PLN se utilizan en aplicaciones como chatbots y asistentes virtuales, y los desarrollos recientes como GPT-3 tienen el potencial de revolucionar las aplicaciones basadas en el lenguaje.

El Procesamiento del Lenguaje Natural (PLN) es un campo de la inteligencia artificial que se ocupa de la interacción entre las computadoras y el lenguaje humano. El objetivo del PLN es permitir que las computadoras comprendan, interpreten y generen lenguaje humano. Se ha vuelto cada vez más importante en los últimos años a medida que se genera más y más datos en lenguaje natural, como correos electrónicos, publicaciones en redes sociales y opiniones de clientes.

- Conceptos básicos del Procesamiento del Lenguaje Natural

- El PLN implica varios procesos clave, como el procesamiento de texto, el análisis sintáctico, el análisis semántico y el análisis discursivo. El procesamiento de texto implica la limpieza y el preprocesamiento de los datos de texto para eliminar el ruido y la información irrelevante. El análisis sintáctico implica analizar el texto en componentes gramaticales como sustantivos, verbos y adjetivos. El análisis semántico implica comprender el significado del texto mediante el análisis de las relaciones entre las palabras y el contexto en el que se utilizan. Por último, el análisis del discurso implica el análisis de unidades más grandes del lenguaje, como párrafos y documentos enteros, para comprender el significado y propósito general del texto.

- Aplicaciones del Procesamiento del Lenguaje Natural El PLN tiene muchas aplicaciones en diversas industrias, como la salud, las finanzas y el comercio minorista. En el campo de la salud, el PLN se puede utilizar para extraer información de los registros médicos electrónicos para ayudar en el diagnóstico y tratamiento. En finanzas, el PLN se puede utilizar para analizar artículos de noticias y publicaciones en redes sociales para tomar mejores decisiones de inversión. En el comercio minorista, el PLN se puede utilizar para analizar opiniones y comentarios de los clientes para mejorar el desarrollo de productos y el servicio al cliente.

- Desarrollos recientes en el Procesamiento del Lenguaje Natural Uno de los desarrollos más emocionantes en el PLN es la aparición de GPT-3 (Generative Pretrained Transformer 3), un modelo de lenguaje desarrollado por OpenAI. GPT-3 es uno de los modelos de lenguaje más grandes y potentes jamás creados, con más de 175 mil millones de parámetros. Se puede utilizar para una amplia gama de tareas basadas en el lenguaje, como la traducción de idiomas, la respuesta a preguntas y la generación de texto.

- GPT-3 tiene el potencial de revolucionar muchas industrias al permitir que las computadoras generen lenguaje similar al humano a gran escala. Por ejemplo, se puede utilizar para crear chatbots que puedan tener conversaciones naturales y atractivas con los clientes. También se puede utilizar para crear contenido para sitios web, como descripciones de productos y artículos de noticias.

- El Procesamiento del Lenguaje Natural es un campo en rápido crecimiento con muchas aplicaciones en diversas industrias. Implica varios procesos clave, como el procesamiento de texto, el análisis sintáctico, el análisis semántico y el análisis discursivo. Los desarrollos recientes en el PLN, como la aparición de GPT-3, tienen el potencial de revolucionar muchas industrias al permitir que las computadoras generen lenguaje similar al humano a gran escala. A medida que la cantidad de datos generados en lenguaje natural sigue aumentando, la importancia del PLN seguirá creciendo.

Visión por Computadora

La visión por computadora es un subcampo de la IA que se centra en permitir que las máquinas interpreten y comprendan la información visual del mundo que las rodea. Los algoritmos de visión por computadora se utilizan en aplicaciones como el reconocimiento de imágenes, la detección de objetos y el reconocimiento facial.

La visión por computadora es un campo de la inteligencia artificial que permite a las máquinas analizar e interpretar datos visuales del mundo que las rodea. Implica el desarrollo de algoritmos y técnicas que pueden permitir a las máquinas procesar, analizar y comprender imágenes y videos de manera similar a como lo hacen los humanos.

Historia de la visión por computadora: La historia de la visión por computadora se remonta a la década de 1950, cuando los investigadores comenzaron a explorar formas de permitir que las máquinas reconocieran e interpretaran patrones visuales. Sin embargo, no fue hasta la década de 1990 que el campo comenzó a ganar impulso significativo, gracias al desarrollo de hardware informático más rápido y la disponibilidad de grandes conjuntos de datos para entrenar modelos de visión por computadora.

Desarrollos recientes: Los desarrollos recientes en visión por computadora han sido impulsados por avances en el aprendizaje profundo, un subcampo del aprendizaje automático que implica entrenar redes neuronales en grandes conjuntos de datos para reconocer y clasificar patrones visuales. El aprendizaje profundo ha permitido que los algoritmos de visión por computadora logren un rendimiento similar al humano en tareas como el reconocimiento de imágenes, la detección de objetos y el reconocimiento facial.

Aplicaciones de la visión por computadora: La visión por computadora tiene numerosas aplicaciones en una amplia variedad de industrias, incluyendo:

- Salud: La visión por computadora puede usarse para analizar imágenes médicas como radiografías, resonancias magnéticas y tomografías computarizadas para ayudar a los médicos a diagnosticar y tratar enfermedades.

- Automotriz: La visión por computadora puede usarse en autos autónomos para detectar y evitar obstáculos y navegar por las carreteras.

- Retail: La visión por computadora puede usarse en el comercio minorista para hacer un seguimiento del inventario y analizar el comportamiento del cliente.

- Seguridad: La visión por computadora puede usarse en sistemas de seguridad para detectar e identificar posibles amenazas.

- Agricultura: La visión por computadora puede usarse en agricultura para monitorear la salud y el rendimiento de los cultivos.

- Robótica: La visión por computadora puede usarse en robótica para permitir que las máquinas perciban e interactúen con su entorno.

Tipos de tareas de visión por computadora:

- Reconocimiento de imagen: El reconocimiento de imagen implica identificar objetos y patrones en imágenes fijas.

- Detección de objetos: La detección de objetos implica identificar objetos dentro de un flujo de imágenes o video y localizarlos con un cuadro delimitador.

- Reconocimiento facial: El reconocimiento facial implica identificar individuos en función de sus características faciales.

- Segmentación semántica: La segmentación semántica implica dividir una imagen en múltiples segmentos y asignar una etiqueta a cada segmento.

- Reconocimiento óptico de caracteres (OCR): OCR implica reconocer e interpretar texto en imágenes.

En conclusión, la visión por computadora es un campo en rápida evolución con numerosas aplicaciones en varias industrias. Los desarrollos recientes en aprendizaje profundo han permitido que los algoritmos de visión por computadora logren un rendimiento similar al humano en tareas como el reconocimiento de imágenes, la detección de objetos y el reconocimiento facial. A medida que el campo continúa evolucionando, tiene el potencial de transformar muchos aspectos de nuestra vida diaria.

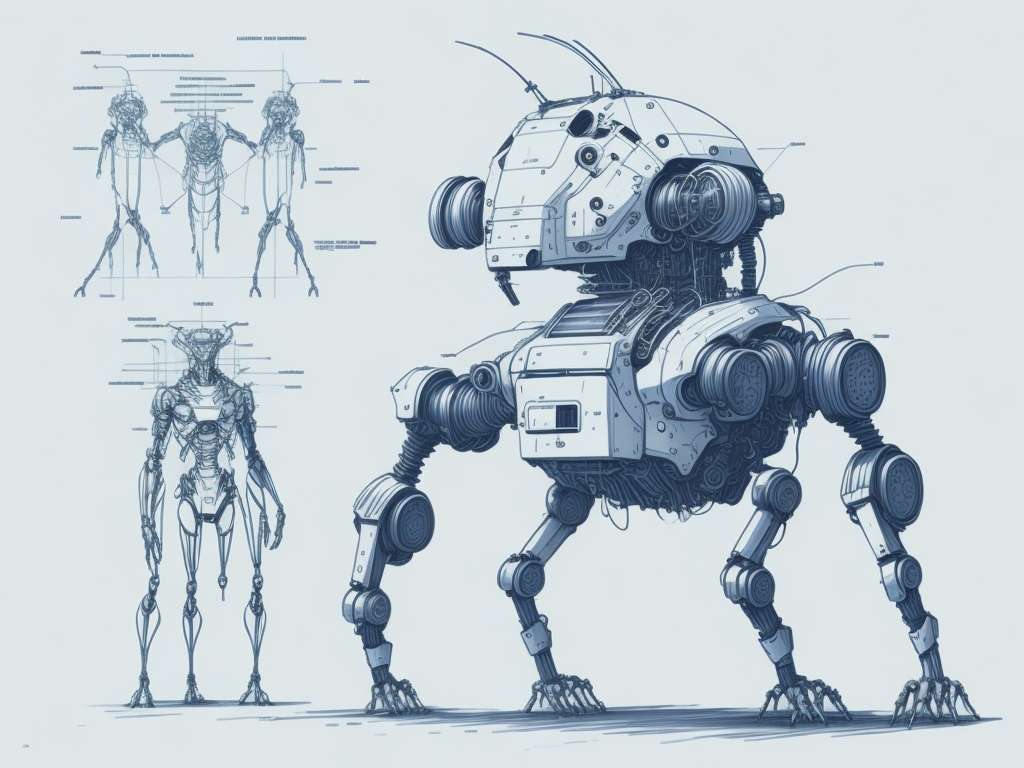

Robótica

La robótica es la integración de la IA con máquinas físicas, lo que les permite realizar tareas que de otra manera serían difíciles o imposibles para los humanos. Los desarrollos recientes en robótica, como la aparición de robots colaborativos (cobots), tienen el potencial de revolucionar la fabricación y otras industrias.

La robótica es un campo de la ingeniería y la ciencia que se centra en el diseño, construcción y operación de robots. Los robots son máquinas programables que pueden realizar una variedad de tareas con precisión y precisión. La robótica ha existido durante décadas, pero los avances recientes en inteligencia artificial y aprendizaje automático han impulsado el campo a nuevas alturas.

En esta guía, cubriremos el estado actual de la robótica y su integración con la IA. Proporcionaremos una visión general de los desarrollos recientes en robótica, incluida la aparición de robots colaborativos (cobots) y sus posibles usos en la fabricación y otras industrias.

Historia de la robótica La historia de la robótica se remonta al principio del siglo XX, con el primer robot conocido siendo el “Televox”, creado en 1927 por el ingeniero estadounidense John Hammond. El robot era capaz de comandos de voz simples y se usaba con fines de entretenimiento.

Con el tiempo, los robots han evolucionado desde máquinas simples hasta sistemas complejos capaces de realizar una variedad de tareas. En la década de 1960, General Motors instaló el primer robot industrial en su fábrica, lo que marcó el comienzo del uso de robots en la fabricación. Desde entonces, los robots se han convertido en una parte esencial del proceso de fabricación, con muchas fábricas utilizándolos para automatizar tareas y mejorar la eficiencia.

Desarrollos recientes en robótica En los últimos años, la robótica ha dado grandes pasos tanto en hardware como en software. Los avances en el aprendizaje automático y la inteligencia artificial han permitido que los robots realicen tareas más complejas e interactúen con los humanos de manera más natural.

Uno de los desarrollos más significativos en robótica ha sido la aparición de robots colaborativos, o cobots. Estos son robots diseñados para trabajar junto a los humanos, proporcionando asistencia y realizando tareas que requieren altos niveles de precisión y exactitud. Los cobots están equipados con sensores que les permiten detectar la presencia de humanos y ajustar su comportamiento en consecuencia, lo que los hace seguros para trabajar.

Aplicaciones de la robótica Las aplicaciones de la robótica son vastas y continúan expandiéndose a medida que avanza la tecnología. En la fabricación, los robots se utilizan para automatizar tareas como soldadura, pintura y ensamblaje. También se utilizan en la industria de la salud para realizar tareas como cirugía y cuidado de pacientes. En la agricultura, los robots se utilizan para tareas como plantación y cosecha de cultivos.

Otra aplicación emergente de la robótica está en el campo de la logística y el almacenamiento. Se utilizan robots para mover y transportar bienes, aumentando la eficiencia y reduciendo los costos laborales. En el futuro, se espera que los robots desempeñen un papel importante en la industria del transporte, con automóviles y camiones autónomos cada vez más comunes.

Integración de IA con robótica La integración de la inteligencia artificial con la robótica ha abierto nuevas posibilidades para el campo. Los robots ahora son capaces de aprender y adaptarse a su entorno, lo que los hace más versátiles y capaces de realizar una gama más amplia de tareas.

Uno de los ejemplos más significativos de la integración de IA y robótica está en el campo de los vehículos autónomos. Los automóviles y camiones autónomos utilizan una combinación de sensores, cámaras y algoritmos de aprendizaje automático para navegar por carreteras y autopistas. Pueden detectar otros vehículos, peatones y obstáculos y ajustar su comportamiento en consecuencia.

Conclusión En conclusión, la robótica es un campo en rápida evolución que está preparado para revolucionar muchas industrias. Con los avances en inteligencia artificial y aprendizaje automático, los robots se están volviendo más inteligentes y capaces de realizar tareas complejas. La integración de la IA y la robótica continuará creando nuevas oportunidades y aplicaciones, haciendo que el futuro de la robótica sea emocionante.

[…] Introducción a la Inteligencia Artificial: Una breve descripción de la IA, su historia y conceptos… […]